交換器的連接方式大家應該都知道,一共有三種,分別是:級聯、堆疊和叢集。今天, 大家就詳細討論一下交換器的這三種連接方式及彼此間的差別吧!

交換器的級聯技術一般用來實現多台交換器之間的互連接;堆疊技術用來將多台交換器組成一個單元,從而提高更大的端口密度和更高的性能;集群技術用來將相互連接的多台交換器作為一個邏輯設備進行管理,從而降低網路管理成本,簡化管理操作。

01 級聯級聯可以定義為兩台或兩台以上的交換器透過一定的方式相互連接。根據需要,多台交換器可以以多種方式進行級聯。在較大的區域網路例如校園網路中,多台交換器依照效能和用途一般形成匯流排型、樹型或星型的級聯結構。

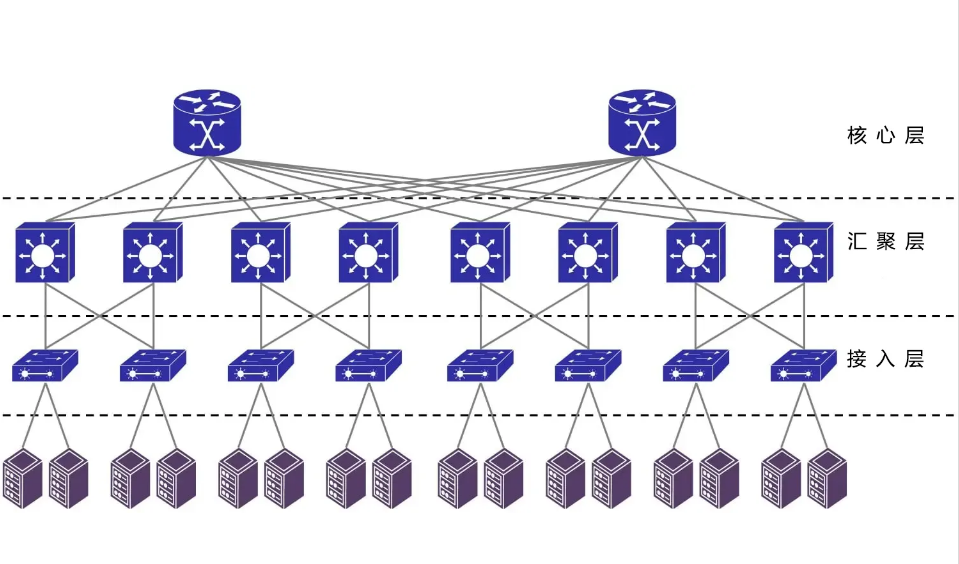

城域網路是交換器級聯的絕佳範例。目前各地電信部門已經建置了許多市地級的寬頻IP城域網路。這些大款城域網路自上向下一般分為3個層次:核心層、匯聚層、接取層。核心層一般採用千兆乙太網路技術、匯聚層採用1000M/100M 乙太網路技術,接取層採用100M/10M 乙太網路技術,所謂 “千兆到大樓,百兆到樓層,十兆到桌面 ” 。

這種結構的寬頻城域網路其實就是由各層級的許多台交換器級聯而成的。核心交換機(或路由器)下連若干台匯聚交換機,匯聚交換機下聯若干台小區中心交換機,小區中心交換機下連若干台樓宇交換機,樓宇交換機下連若干台樓層(或單元)交換機(或集線器)。

交換器一般是透過普通用戶連接埠進行級聯,有些交換器則提供了專門的級聯連接埠。這兩種連接埠的差異僅在於一般連接埠符合MDI 標準,而級聯連接埠 ( 或稱為上行口 ) 符合 MDIX標準。由此導致了兩種方式下接線方式不同:當兩台交換器都通過普通端口級聯時, 端口間電纜採用直通電纜(Straight Throurh Cable) ;當且僅當中一台通過級聯端口時,採用交叉電纜(Crossover Cable) 。

為了方便進行級聯,某些交換器上提供了一個兩用連接埠(MDI 或MDIX),可以透過開關或管理軟體將其設定為MDI(MDI是正常的UTP或STP連接) 或MDIX(連接器的傳送和接收對是在內部反接的,這就使得不同的設備(如集線器-集線器或集電器-交換機),可以利用常規的UTP或STP電纜實現背靠背的級聯)方式。更進一步,某些交換器上全部或部分連接埠具有 MDI/MDIX 自校準功能,可自動區分網路線類型,進行連鎖時更方便。

進行級聯的時候需要注意,原則上任何廠商、任何型號的乙太網路交換器均可進行級聯,單頁不排除在一些特殊情況下兩台交換器無法進行級聯。交換器間級聯的層數是有一定限度的。成功實現級聯的最根本原則就是任兩個站點之間的距離不能超過媒體段的最大跨距。多台交換器級聯時,應確保它們都支援生成樹協議,既要防止網內出現環路,又要允許冗餘鏈路存在。

進行級聯時,應盡力確保交換器間的中繼鏈路具有足夠的頻寬,為此可採用全雙工技術和鏈路匯聚技術。交換器埠採用全雙工技術後,不但對應埠的吞吐量加倍,而且交換器間終極距離大大增加,使得異地分佈、距離較遠的多台交換器級聯成為可能。鏈路匯聚也稱為連接埠匯聚、連接埠捆綁、連結擴容組合,由IEEE802.3ad 標準定義。即兩台設備之間透過兩個以上的同種類型連接埠並進行連接,同時傳輸數據,以便提供更高的頻寬、更好的冗餘度以及實現負載平衡。

需要注意的是,並非所有類型的交換器都支援這兩種技術。

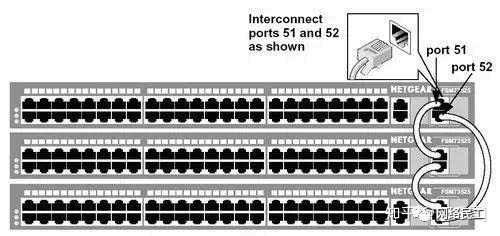

02堆疊堆疊是指將一台以上的交換機組合起來共同工作,以便在有限的空間內提供盡可能多的端口多台交換機經過堆疊形成一個堆疊單元,可堆疊的交換機性能指標中有一個“最大可堆疊數”,它指的就是一個堆疊單元中所能堆疊的最大交換機數,代表一個堆疊單元中多能提供的最大端口密度。

堆疊與級聯這兩個概念既有區別又有連結。堆疊可以看作是級聯的特殊情況。它們的不同之處在於:級聯的交換器之間可以相距很遠(在媒體許可範圍內),而一個堆疊單元內的多台交換機之間的距離非常近,一般不超過幾米;級聯一般採用普通端口,而堆疊一般採用專用的堆疊模組和堆疊電纜。一般來說,不同廠商、不同型號的交換器可以互相級聯,堆疊則不同,它必須在可堆疊的同類型交換機之間進行;級聯僅僅是交換器之間的簡單連接,堆疊則是將整個堆疊單元作為交換器來使用,這不僅意味著連接埠密度的增加,而且意味著系統頻寬的加寬。

目前,市場上的主流交換器可以細分為可堆疊型和非堆疊型兩大類。而號稱可以堆疊的交換器中,又有虛擬堆疊和真正堆疊之分。所謂的虛擬堆疊,實際上就是交換器之間的級聯。交換器並不是透過專用堆疊模組和堆疊電纜,而是透過Fast Ethernet 連接埠或 Giga Ethernet 連接埠進行堆疊,實際上就是一種變相的級聯。即便如此,虛擬堆疊的多台交換器多台交換器在網路中已經可以作為一個邏輯設備進行管理,從而使網路管理變得簡單起來。真正意義上的堆疊需要滿足:採用專用堆疊模組和堆疊總線進行堆疊,不佔用網路端口,多台交換器堆疊後,具有足夠的系統頻寬,從而確保堆疊後每個端口仍能達到線速交換;多台交換器堆疊後, VLAN等功能不受影響。

目前市面上有相當一部分可堆疊的交換器屬於虛擬堆疊類型而非真正堆疊類型。很顯然,真正意義上的堆疊比虛擬堆疊在性能上要高出許多,但採用虛擬堆疊至少有兩個好處:虛擬堆疊往往採用標準Fast Ethernet 或Giga Ethernet 作為堆疊總線, 易於實現,成本較低;堆疊連接埠可以作為普通連接埠使用, 有利於保護用戶投資。採用標準 Fast Ethernet 或 Giga Ethernet連接埠實現虛擬堆疊,可以 大幅延伸堆疊的範圍 ,使得堆疊不再局限於一個機櫃之內。

堆疊可以大大提高交換器連接埠密度和效能。堆疊單元具有足以匹敵大型機架式交換器的端口密度和性能, 而投資卻比機架式交換機便宜得多 ,實現起來也靈活得多。這就是堆疊的優勢。

機架式交換器可以說是堆疊發展到更高階段的產物。機架式交換機一般屬於部門以上級別得交換機,它有多個插槽,連接埠密度大,支援多種網路類型,擴充性較好,處理能力強,但價格昂貴。

03集群所謂集群,就是將多台互相連接(級聯或堆疊)的交換器作為一個邏輯設備進行管理。急群眾,一般只有一台起到管理作用的交換機,成為命令交換機,它可以管理若干台其他交換機。在網路中,這些交換器只需要佔用一個IP位址節約了IP位址。在命令交換機統一管理下,集群中多台交換器協同工作,大幅降低管理強度。

例如, 管理員只需要透過命令交換器就可以對叢集中所有交換器進行版本升級。

集群技術為網路管理工作帶來的好處是毋庸置疑的。但要使用這項技術,應當注意到,不同廠商對集群有不同的實現方案, 一般廠商都是採用專有協議實現集群的 。這決定了集群技術有其限制。不同廠商的交換器可以級聯,但不能集群。即使同一廠商的交換機,也只有指定的型號才能實現集群 。

標籤: 350-601

資料中心五大核心架構設計

資料中心架構是現代設施、IT 和網路系統的複雜集成,這些組件協同工作以建立、設計和支援關鍵業務應用程式。這些系統是高度互聯的,需要對其設計和操作進行精心規劃和同步的方法。

資料中心架構包含了實體基礎架構(例如配電和冷卻系統)和 IT 基礎架構(套件網路架構、儲存架構、伺服器架構和雲端資料中心架構)的設計和佈局。它涉及對實體空間、電源和冷卻系統、網路連接、安全措施和軟體的詳細規劃,以確保 IT 資源和服務的最佳效能、可靠性和可擴展性。最終目標是創建一個高效、有彈性和安全的環境,用於承載現代企業和組織的關鍵 IT 基礎設施。

資料中心架構的元件

伺服器:根據其實體結構和大小分為不同的類型,包括機架式伺服器、刀鋒式伺服器和塔式伺服器

儲存系統:資料中心使用儲存區域網路 (SAN)、網路附加儲存 (NAS) 和直連儲存 (DAS) 等各種儲存技術來儲存和管理數據

網路設備:交換器、路由器、防火牆和負載平衡器在資料中心內和外部網路之間提供高效率的資料通訊和安全性

電力基礎設施:不間斷電源 (UPS) 系統、備用發電機和配電單元 (PDU) 為資料中心設備提供穩定可靠的電源

冷卻系統:機房空調 (CRAC) 裝置、液體冷卻系統和冷/熱通道密封可保持最佳溫度和濕度水平,使硬體正常運作

機櫃:資料中心使用的機架和機櫃包括開放式機架(兩柱式和四柱式機架)、封閉式機架、壁掛式機架和網路機櫃

佈線:結構化佈線系統,包括雙絞線電纜(用於以太網,如 Cat5e、Cat6)、光纖電纜(單模和多模)和同軸電纜

安全系統:生物辨識存取控制、監視攝影機和安全人員等實體安全措施,以及防火牆、入侵偵測/防禦系統(IDS/IPS) 和加密等網路安全解決方案可保護資料中心免受未經授權的存取和威脅

管理軟體:資料中心基礎設施管理 (DCIM) 軟體有助於監控、管理和最佳化資料中心元件的效能和能源效率

01、資料中心的網路架構

資料中心網路架構是指促進資料中心內通訊和資料交換的互連節點和路徑的設計和佈局。它包括網路設備(如交換器、路由器和電纜)的實體和邏輯佈局,以實現伺服器、儲存系統、防火牆和負載平衡器之間的高效資料傳輸。適當的網路架構可提供高速、低延遲和可靠的連接,同時提供可擴展性、安全性和容錯性。

幾十年來,三層架構一直是資料中心網路的標準模型。然而,另一種拓撲結構,即葉脊架構已經出現,並在現代資料中心環境中獲得了突出地位。此體系結構在高效能運算 (HPC) 設定中特別普遍,並已成為雲端服務供應商 (CSP) 的主要選擇。

以下是這兩種不同資料中心網路架構的比較:

▋三層資料中心網路架構

三層資料中心網路架構是一種傳統的網路拓撲結構,在許多較舊的資料中心中已被廣泛採用,通常被稱為「核心-匯聚-存取」模型。冗餘是這個設計的關鍵部分,除了幫助網路實現高可用性和高效資源分配外,還有從存取層到核心的多條路徑。

存取層:作為三層資料中心網路架構中的最低層,它可作為伺服器、儲存系統和其他裝置進入網路的入口點,透過交換器和電纜提供連接。存取層交換器通常以架頂式 (ToR) 配置排列,強制執行安全設定和 VLAN(虛擬區域網路)指派等策略

聚合層:也稱為分佈層,它整合來自存取層架頂式交換器的資料流量,然後將其傳輸到核心層以路由到其最終目的地。此層透過冗餘交換器增強資料中心網路的彈性和可用性,消除單點故障,並透過負載平衡、服務品質 (QoS)、資料包過濾、佇列和 VLAN 間路由等策略來控製網路流量

核心層:它也稱為主幹網,是網路的高容量中心部分,專為冗餘和彈性而設計,將聚合層交換器互連並連接到外部網路。核心層在 3 層運行,使用高階交換器、高速電纜和收斂時間較短的路由協議,優先考慮速度、最小延遲和連接性

伺服器虛擬化技術帶來的層間多跳延遲,會產生的大量的東西向(伺服器到伺服器)流量,傳統的三層資料中心架構難以有效處理, 同時還存在頻寬的浪費、故障域較大、難以適應超大規模網路等問題。

資料中心的流量總的來說可以分為以下幾種:

· 南北向流量:資料中心以外的客戶端到資料中心伺服器之間的流量,或資料中心伺服器存取網際網路的流量。

· 東西向流量:資料中心內的伺服器之間的流量。

· 跨資料中心流量:不同資料中心的流量,例如資料中心之間的災備,私有雲和公有雲之間的通訊。

在傳統資料中心中,業務通常採用專線方式部署。通常,服務部署在一個或多個實體伺服器上,並與其他系統實際隔離。因此,傳統資料中心東西向流量較低,南北向流量約佔資料中心總流量的80%。

在雲端資料中心,服務架構逐漸從單體架構轉變為Web-APP-DB,分散式技術成為企業應用的主流。服務的元件通常分佈在多個虛擬機器或容器中。該服務不再由一台或多台實體伺服器運行,而是由多台伺服器協同工作,導致東西向流量快速增長。

此外,大數據服務的出現使分散式運算成為雲端資料中心的標準配置。大數據服務可以分佈在一個資料中心的數百台伺服器上進行平行計算,這也大大增加了東西向流量。

傳統的三層網路架構是為南北向流量占主導地位的傳統資料中心設計的,不適合東西向流量較大的雲端資料中心。

一些東西向流量(如跨POD的二層和三層流量)必須經過匯聚層和核心層的設備轉發,不必要地經過許多節點。傳統網路通常設定1:10到1:3的頻寬超額比,以提高設備使用率。隨著超額訂閱率,每次流量通過節點時效能都會顯著下降。此外,第 3 層網路上的 xSTP 技術加劇了這種惡化。

因此,如果透過傳統三層網路架構運行大量的東西向流量,連接到同一交換器連接埠的裝置可能會爭奪頻寬,導致最終用戶獲得的回應時間很差。

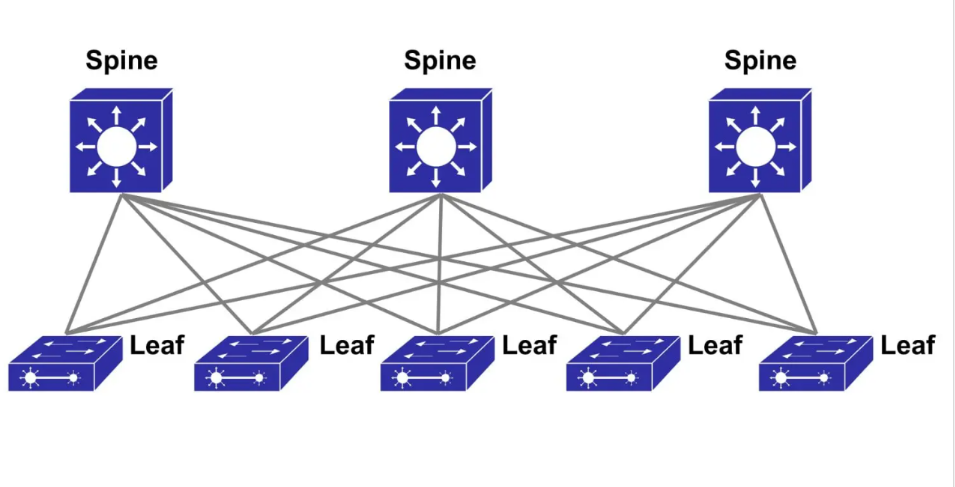

▋Spine-Leaf 葉脊架構

脊葉架構,通常稱為 Clos 設計,是一種兩層網路拓撲,廣泛用於資料中心和企業 IT 環境。與傳統的三層網路架構相比,它為資料中心基礎設施帶來了多種優勢,例如可擴展性、減少延遲和提高效能。

葉子層:這些是接取層中的架頂式交換機,用於連接到機架內的伺服器和儲存設備。它們透過連接到每個主幹交換器形成一個完整的網狀網絡,確保所有轉送路徑都可用,並且節點在跳數方面等距

脊椎層:它們構成了資料中心網路的骨幹網,將所有枝葉交換器互連並在它們之間路由流量。它們不會直接相互連接,因為網狀網路架構消除了主幹交換器之間專用連接的需要。相反,它們透過主幹層路由東西向流量,以實現不同葉交換器上的伺服器之間的完全無阻塞資料傳輸

與傳統的三層架構相比,脊葉架構具有卓越的可擴展性、更低的延遲、可預測的效能和最佳化的東西向流量效率。它還透過高度互連提供容錯能力,消除了網路環路問題,並簡化了資料中心網路管理。

但是,Fabric 架構並非完美。葉節點網路設備無論是效能需求或功能需求,均高於傳統架構下的接取設備,其作為各種類型的閘道器(二三層間、VLAN/VxLAN 間、VxLAN/NVGRE 間、FC/IP 間等等),晶片處理能力要求較高,目前尚無滿足所有協定間互通的商用晶片;由於不存在相關的標準,為了實現各種類型網路的接入,其骨幹節點與葉子節點間的轉發各個廠商均採用了私有封裝,這也為未來的互通設定了難題。除此之外,還有:

獨立的 L2 Domain 限制了依賴 L2 Domain 應用程式的部署。要求部署在一個二層網路的應用程序,現在只能部署下一個機架下了。獨立的 L2 Domain 限制了伺服器的遷移。遷移到不同機架之後,網關和 IP 位址都要變。

子網數量大大增加了。每個子網路對應資料中心一條路由,現在相當於每個機架都有一個子網,對應於整個資料中心的路由條數大大增加,並且這些路由資訊要怎麼傳遞到每個Leaf 上,也是一個複雜的問題。

在設計葉脊網路架構之前,您必須先確定一些重要的因素。如,收斂比(即超額預訂比率)、葉交換機與脊交換機的比例、從葉層到脊層的上行鏈路、構建在第2層或第3層等。

02、資料中心的儲存架構

資料中心儲存架構是指儲存系統的設計和組織,它決定如何在資料中心內實體儲存和存取資料。它定義了實體儲存設備類型,如硬碟(HDD)、固態驅動器(SSD) 和磁帶驅動器,以及它們的配置方式,例如直連儲存(DAS)、網路連接儲存(NAS) 和儲存區域網路(SAN )。此外,儲存架構還涉及伺服器直接或透過網路存取儲存資料的方法。

以下是資料中心儲存架構的主要類型:

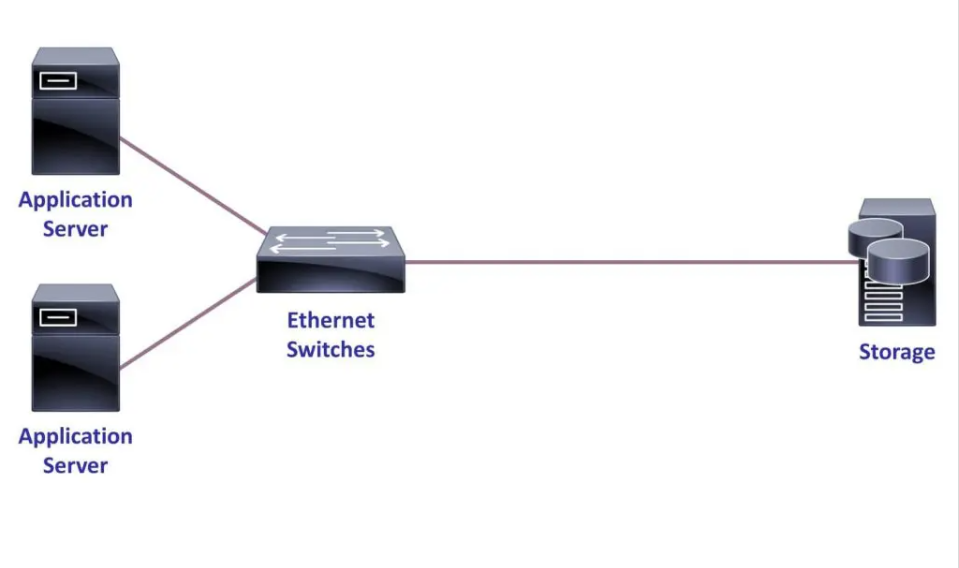

▋直連儲存 (DAS)

直連儲存 (DAS) 是一種用於資料中心的數位儲存系統,其特點是與其支援的伺服器直接實體連接,中間沒有網路連接。伺服器使用 SATA、SCSI 或 SAS 等協定與儲存設備通信,RAID 控制器管理資料條帶化、鏡像和磁碟管理。

DAS 為單一伺服器提供經濟高效、簡單和高效能,但與 NAS 和 SAN 等網路儲存解決方案相比,在可擴展性和可存取性方面有其限制。

▋網路連接儲存 (NAS)

網路連線儲存 (NAS) 是一種專用的檔案級儲存設備,可透過區域網路 (LAN) 中的 TCP/IP 乙太網路為多個使用者和用戶端設備提供資料存取。這些系統旨在簡化資料儲存、檢索和管理,而無需中間應用伺服器。

NAS 提供了輕鬆存取、共享和管理的優勢,但由於其對共享網路頻寬的依賴性和物理限制,它面臨可擴展性和效能限制。

▋儲存區域網路 (SAN)

儲存區域網路 (SAN) 是專用的高速網絡,通常使用光纖通道協定將伺服器連接到共用儲存裝置。這些系統提供對資料中心內儲存的區塊級訪問,使伺服器能夠與儲存裝置進行交互,就好像它們被直接連接一樣,透過從主機伺服器卸載這些任務來簡化備份和維護等操作。 SAN 提供了高效能和可擴展性,但它們具有高成本和複雜的管理要求,需要專門的 IT 專業知識。

▋下一代儲存解決方案與技術

資料中心儲存領域正在湧現多種創新的下一代解決方案和技術,以滿足對效率、可擴展性和效能日益增長的需求。這些包括:

全快閃陣列:使用固態硬碟 (SSD) 取代傳統旋轉硬碟機 (HDD) 的高速儲存系統,提供卓越的效能和更低的延遲。此外,專為SSD 設計的儲存協定(如NVMe(非揮發性記憶體快速)和NVMe-OF(NVMe over Fabric))的採用率不斷提高,進一步提高了資料中心全快閃陣列的效能、減少延遲和吞吐量

橫向擴展檔案系統:一種儲存架構,允許透過添加更多節點來水平擴展儲存容量和效能,支援靈活性和易於擴展

物件平台:專為管理大量非結構化資料而設計的儲存解決方案,使用扁平命名空間和唯一識別碼進行資料檢索

超融合基礎架構 (HCI):將儲存、運算和網路整合到一個框架中的整合系統,可簡化管理並增強可擴充性

軟體定義儲存 (SDS):一種軟體管理和抽象底層儲存資源的方法,透過基於策略的管理提供靈活性和效率。 SDS 技術已被 Meta Platforms (Facebook)、Google 和 Amazon 等多家超大規模公司採用

熱輔助磁記錄 (HAMR):一種資料儲存技術,它使用局部加熱來增加磁記錄密度,使更高容量的硬碟 (HDD) 能夠滿足現代資料中心不斷增長的儲存需求

03、資料中心的伺服器架構

資料中心的伺服器架構是指伺服器和相關元件的設計和組織,以有效處理、儲存和管理資料。

它通常可以分為以下幾類:外形尺寸(物理結構)、系統資源和支援基礎設施:

外形尺寸(物理結構)

機架式伺服器:這些是資料中心中最常見的伺服器類型。它們設計用於安裝在標準的 19 吋機架中,高度通常為 1U 至 4U

刀鋒伺服器:這些伺服器旨在最大限度地提高密度並最大限度地減少實體空間。多個刀鋒伺服器安裝在一個機箱中,共享電源、冷卻和網路等公共資源

塔式伺服器:雖然在大型資料中心中較不常見,但塔式伺服器仍用於較小規模的部署或機架空間不受限制的地方。它們類似於桌上型電腦塔,可以是獨立的單元

系統資源

CPU(中央處理器):CPU是伺服器的大腦,負責執行指令和處理資料。它執行算術、邏輯和輸入/輸出運算

記憶體:RAM(隨機存取記憶體)是伺服器的主記憶體,提供對資料和指令的快速存取。它會暫時儲存目前正在使用的資料和程序

儲存:硬碟 (HDD) 或固態硬碟 (SSD) 等裝置會永久儲存資料和檔案。它們保存作業系統、應用程式、資料庫和使用者數據

網路:NIC(網路介面卡)將伺服器連接到網絡,從而實現與其他設備的通訊。它們處理資料包的發送和接收

GPU(圖形處理單元):GPU 是專為平行處理和圖形渲染而設計的專用處理器。他們擅長處理計算密集型任務,尤其是人工智慧、機器學習和科學模擬的任務。但是,並非所有伺服器都需要 GPU

支援基礎設施

電源系統:電源單元 (PSU) 為所有伺服器元件提供穩定可靠的電源。它們將來自牆上插座的交流電源轉換為伺服器所需的適當直流電壓

空調系統:伺服器會產生大量熱量,冷卻系統確保組件在安全溫度範圍內運作。冷卻選項包括伺服器機房中的風扇、散熱器、液體冷卻和空調

主機板架構:這是將所有伺服器元件連接在一起的主要印刷電路板。它為 CPU、RAM、儲存和其他週邊設備提供必要的介面、匯流排和插槽

04、雲端資料中心架構

雲端資料中心架構是指在遠端資料中心內設計和組織運算、儲存、網路和資料庫資源,以實現雲端運算服務的交付。該架構基於虛擬化技術構建,允許高效共享和利用實體資源,以提供可擴展、可靠且靈活的基於雲端的應用程式和服務。

以下是雲端資料中心架構主要元件的細分:

運算:雲端運算服務為執行應用程式和工作負載提供虛擬機器 (VM)、容器和無伺服器運算資源。這些服務允許用戶按需配置和擴展運算能力,而無需管理實體硬體。例如,主要的雲端運算服務包括Amazon EC2,Microsoft的Azure虛擬機器和Google Cloud的運算引擎

儲存:雲端儲存服務為各種資料類型(如檔案、物件和備份)提供可擴充且持久的儲存解決方案。這些服務提供高可用性、自動複製和資料加密,以確保資料的完整性和安全性。流行的雲端儲存服務的範例包括 Amazon S3、Microsoft 的 Azure Blob 儲存體和 Google 的雲端存儲

網路:雲端網路服務使用戶能夠建立、配置和管理虛擬網路、子網路和網路安全規則。這些服務提供雲端資源、本地網路和 Internet 之間的連接,從而實現安全且有效率的資料傳輸。例如,關鍵的雲端網路服務包括 Amazon Virtual Private Cloud (VPC)、Microsoft 的 Azure 虛擬網路和 Google Cloud Virtual Private Cloud (VPC)

資料庫:雲端資料庫服務提供託管和可擴展的資料庫解決方案,用於儲存、檢索和管理結構化和非結構化資料。這些服務支援各種資料庫引擎,例如關聯式資料庫(例如 MySQL、PostgreSQL)、NoSQL 資料庫(例如 MongoDB)和資料倉儲。雲端資料庫服務可處理配置、擴充、備份和安全性等任務,使開發人員能夠專注於應用程式開發。例如,著名的雲端資料庫服務包括Amazon RDS,Microsoft的Azure Cosmos DB和Google Cloud SQL

05、實體資料中心設計

資料中心的實體架構和設計對於確保最佳效能、安全性和可靠性至關重要。

以下是實體資料中心架構設計的關鍵要素:

選址

地點:資料中心通常建在自然災害風險較低的地區,遠離地震、洪水和颶風多發地區

氣候:較冷的位置可以透過使用環境空氣來降低冷卻資料中心的成本,而較熱的氣候需要更節能的冷卻解決方案

交通:該地點必須方便工作人員進入,並靠近主要道路和機場,以便運輸設備和緊急應變

電源:可靠且具成本效益的能源至關重要。多條高壓輸電線路和變電站的存在對於電力傳輸很重要

線路資源:靠近主要光纖線路並擁有多個服務供應商,可實現更好的連接性

建築和結構

建築材料:資料中心通常使用耐用的耐火材料建造,例如混凝土、鋼材和專用牆板

結構:雖然單層資料中心較為普遍,但多層資料中心越來越多地建在土地可用性有限或房地產成本高的地區

天花板高度:高天花板高度(通常在 12 到 18 英尺之間)是必要的,以容納活動地板、架空電纜橋架和空調管道,同時為設備和維護提供足夠的間隙

承重能力:資料中心需要較高的地板負載能力,以支援重型伺服器機架、冷卻系統和不間斷電源 (UPS) 系統的重量。承載能力通常在每平方英尺 150 到 300 磅之間

內部佈局:資料中心的內部架構,包括柱子和隔間牆,在設施的整體設計和功能中起著至關重要的作用。這些因素會影響空間利用率、與冷卻系統相關的氣流、配電以及設備的運輸,以便進行維護

▋資料中心功能定位

資料中心的設計和建置基於各種架構因素,例如規模、用途、所有權和位置。通常的資料中心類型包括:

企業資料中心:由各個公司擁有和經營,以支援其特定的業務需求和應用程式。它們通常是量身定制的,這意味著它們是定制的,以滿足單一組織的特定需求。

主機託管資料中心:提供共享基礎架構,多個客戶可以租用空間、電源和冷卻,在託管設施中容納自己的 IT 設備。

超大規模資料中心:大型集中式設施,旨在支援超大規模供應商(CSP)和網路公司的需求。

邊緣資料中心:利用分散式資料中心架構的小型設施。邊緣資料中心位於更靠近最終用戶或資料來源的位置,旨在透過處理更接近其來源的資料來減少延遲並提高應用程式效能。

容器化資料中心:這些資料中心也稱為微型資料中心,是安裝在貨櫃中的模組化便攜式設施,提供靈活性和快速部署。

人工智慧 (AI) 資料中心:針對 AI 工作負載最佳化的專用設施,具有高效能運算、GPU(圖形處理單元)和液體冷卻系統。

來源:資料中心維運管理

什么是思科 ACI

原创 Luke 网工笔记本

和大学同学在聊天时候发现,即使大家都是从网络工程专业毕业,有着相似的背景,不过由于工作经验差别较大,在讨论问题时候时常也会先问一些基础的问题,比如说:什么是思科 ACI ?

之前写过不少关于 ACI 的技术分享,不过确实是忘了写这个基础的信息介绍。为了更好的解释 ACI,我整理了一些信息仅供大家参考。

中英文对照,看不懂中文时候,读英文文档反而更容易理解。

(hardware based) SDN

Cisco Application Centric Infrastructure (ACI) is Cisco’s software-defined networking (SDN) solution for data centers. It aims to simplify, optimize, and accelerate the deployment and management of applications in a highly scalable and agile network environment. ACI achieves this by providing a holistic architecture with centralized automation and policy-driven application profiles.

思科以应用为中心的基础设施 (ACI) 是思科面向数据中心的软件定义网络 (SDN) 解决方案。市场定位是“简化、优化和加速在高度可扩展和敏捷的网络环境中部署和管理应用”。

ACI 通过提供具有集中自动化 (centralized automation) 和策略驱动型应用程序 (policy-driven application profiles) 配置文件的整体架构来实现这一目标。

思科 ACI 的亮点:

Centralized Management and Automation:

集中管理和自动化:

ACI uses the Application Policy Infrastructure Controller (APIC) as the centralized management console. APIC enables network administrators to automate and centrally manage the entire data center network.

ACI 使用应用程序策略基础结构控制器 (APIC) 作为集中式管理控制台。APIC 使网络管理员能够自动化和集中管理整个数据中心网络。

从实际使用体验来说,图形化管理很友好,并且应该是未来的趋势。单纯的徒手敲命令行已经无法很好的管理大规模的网络设备了。

Policy-Driven Architecture:

策略驱动架构:

ACI allows the definition of policies that specify how applications interact with the network. These policies are abstracted from the underlying hardware, enabling easier management and consistency across different environments.

ACI 允许定义指定应用程序如何与网络交互的策略。这些策略是从底层硬件中抽象出来的,从而可以更轻松地跨不同环境进行管理和一致性。 从实际应用来看,这部分可以参考思科 ACI 的 managed objects

Scalability and Flexibility:

可扩展性和灵活性:

The ACI architecture can scale to accommodate thousands of devices and millions of endpoints. It supports a wide range of physical and virtual devices, providing flexibility in deployment.

ACI 架构可以扩展以容纳数千台设备和数百万个端点。它支持各种物理和虚拟设备,提供部署灵活性。

ACI 能够支持数百万个 endpoint 的原因,可以从 ACI Endpoint Manager / EPM 介绍 里面了解一下,ACI 是如何学习/同步 endpoints,如何节省 TCAM 空间。

Security and Micro-Segmentation:

安全和微分段:

ACI provides built-in security features, including micro-segmentation, which allows fine-grained control over network traffic between application components. This enhances security by isolating workloads and limiting the attack surface.

ACI 提供内置的安全功能,包括微分段,允许对应用程序组件之间的网络流量进行细粒度控制。这通过隔离工作负载和限制攻击面来增强安全性。

ACI 要求不同 EPG 之间通信必须配置 contract,同时对于相同 EPG 的 endpoints 如果需要隔离,也可以打开 Intra-EPG contract 功能。

Multi-Cloud and Hybrid Cloud Support:

多云和混合云支持:

ACI extends its policy-driven model to multi-cloud and hybrid cloud environments. This ensures consistent networking and security policies across on-premises data centers and public cloud services.

ACI 将其策略驱动型模型扩展到多云和混合云环境。这可确保跨本地数据中心和公有云服务实现一致的网络和安全策略。

Simplified Troubleshooting and Monitoring:

简化的故障排除和监控:

With tools like Cisco Network Assurance Engine and Telemetry, ACI provides advanced monitoring, troubleshooting, and analytics capabilities. These tools help in identifying and resolving issues proactively.

借助思科网络感知引擎和遥测等工具,ACI 可提供高级监控、故障排除和分析功能。这些工具有助于主动识别和解决问题。

Integration with DevOps Tools:

与 DevOps 工具集成:

ACI integrates with various DevOps tools and platforms, such as Kubernetes, OpenStack, and VMware. This enables seamless deployment and management of containerized and virtualized workloads.

ACI 与各种 DevOps 工具和平台集成,例如 Kubernetes、OpenStack 和 VMware。这样可以无缝部署和管理容器化和虚拟化工作负载。

Enhanced Performance and Efficiency:

增强的性能和效率:

The architecture of ACI optimizes network performance by dynamically adjusting to the needs of applications. This results in improved resource utilization and lower operational costs.

ACI 的架构通过动态调整应用需求来优化网络性能。这样可以提高资源利用率并降低运营成本。

Support for Open Standards:

支持开放标准:

ACI is built on open standards, which ensures interoperability with third-party solutions and protects against vendor lock-in. This provides flexibility in choosing the best-of-breed components for the network.

ACI 建立在开放标准之上,可确保与第三方解决方案的互操作性,并防止供应商锁定。这为为网络选择同类最佳组件提供了灵活性。